KI-Künstler, die nach einer Möglichkeit suchen, die Erstellung von KI-Kunstwerken innerhalb eines stabilen Streamings präziser zu steuern, könnten daran interessiert sein, die Verwendung von ControlNet zu erlernen. Ein stabiles Bereitstellungsmodell, das die Art und Weise verändert hat, wie KI-Künstler Bilder generieren und bearbeiten können. Dieses Modell ermöglicht es Benutzern, menschliche Kompositionen oder Posen aus einem Referenzbild zu kopieren und bietet so ein bisher unerreichtes Maß an Präzision. Dieser Artikel befasst sich mit den Feinheiten der Verwendung von ControlNet und konzentriert sich dabei auf den Image Prompt Adapter und wie er zum Anpassen von KI-Bildern verwendet werden kann.

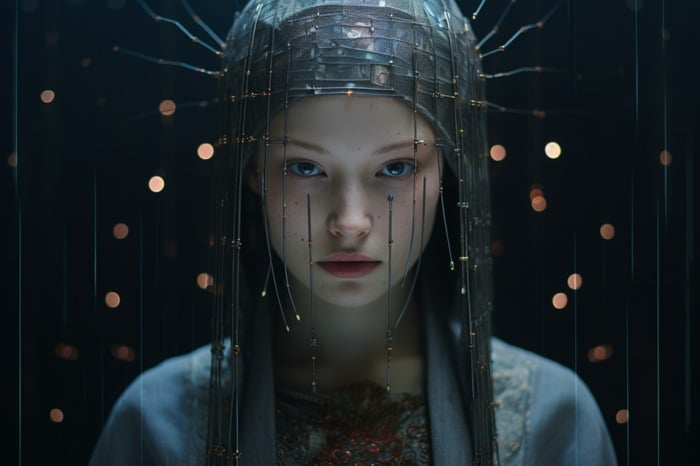

ControlNet ist ein neuronales Netzwerkmodell zur Steuerung stabiler Diffusionsmuster. Es fügt der Textaufforderung, der grundlegendsten Form der Verwendung von SDXL-Vorlagen, eine zusätzliche Konditionierungsebene hinzu. Diese zusätzliche Konditionierung kann unterschiedliche Formen annehmen und es Benutzern ermöglichen, KI-generierte Bilder präzise zu manipulieren. Der Image Prompt Adapter in ControlNet ist ein leistungsstarkes Tool, mit dem Sie eine Person und einen Hintergrund um ein KI-generiertes Gesicht herum erstellen, das Alter, den Haartyp und die Farbe einer Person auf einem Foto ändern oder Elemente in digitaler Kunst modifizieren können.

Wie nutzt man KI-Kunstpersonalisierung mit SDXL und ControlNet?

ControlNet und sein Image Prompt Adapter bieten ein leistungsstarkes Tool zum Bearbeiten und Generieren von KI-Bildern. Ob es darum geht, digitale Kunst zu modifizieren, KI-Bilder zu regenerieren oder aus einem Gesichtsbild einen ganzen Körper und eine Umgebung zu erstellen, ControlNet bietet ein Maß an Präzision und Kontrolle, das bis dahin unerreichbar ist. Mit den richtigen Kenntnissen und Werkzeugen sind die Möglichkeiten der Bildbearbeitung und -generierung nahezu unbegrenzt.

Sehen Sie sich dieses Video auf YouTube an.

Weitere von Stability AI erstellte Artikel zum Thema Stable Diffusion könnten Sie interessieren:

- Stabile Diffusion SDXL Automatische 1111-Tools und GUI

- Juggernaut XL KI-Kunstgenerator basierend auf Stable Diffusion SDXL 1.0

- So verwenden Sie eine stabile Diffusion, um Gesichtsbilder aus Gründen der Konsistenz auszutauschen

- So erstellen Sie konsistente Charaktere in der KI-Kunst von Stable Diffusion

- Wie installiere ich Stable Diffusion SDXL 1.0 Text-zu-Bild-KI-Kunst?

- Verbesserte Leistung von Stable Diffusion XL NVIDIA TensorRT

Um ControlNet nutzen zu können, müssen Benutzer drei Hugging Face IP-Adaptervorlagen sowie die IP-Adapter-Plus-Gesichtsvorlage herunterladen. Die IP-Adapter-Vorlage ist eine Bildaufforderungsvorlage für Text-zu-Bild-Streaming-Vorlagen wie Stable Broadcast und kann in Kombination mit anderen ControlNet-Vorlagen verwendet werden.

Der Arbeitsablauf für die Verwendung des IP-Adaptermodells umfasst die Neugenerierung eines Referenz-KI-Bilds in SDXL und das Hinzufügen von Elementen zum endgültigen Bild mithilfe positiver Eingabeaufforderungen. Dieser Prozess ermöglicht es Benutzern, Elemente in digitaler Kunst mithilfe von ControlNet zu ändern. Benutzer können beispielsweise Inpainting verwenden, um die Haare eines Basis-KI-Bildes zu ändern und das Gesicht eines anderen Basisbildes zu malen. Diese Technik bietet ein gewisses Maß an Kontrolle über den Winkel des Körpers und Gesichts des Motivs und ermöglicht es Benutzern, das Motiv eines Bildes zu ändern, ohne auf Inpainting zurückgreifen zu müssen.

ControlNet-Modelle können auch in Kombination mit anderen Modellen verwendet werden. Beispielsweise kann der animierte Kontrollpunkt Rev verwendet werden, um einen von der KI generierten Vektor eines Hauses zu übernehmen und ihn als animierte Kunst neu zu generieren. Diese Technik kann verwendet werden, um Kunst in verschiedenen Umgebungen und Wetterbedingungen zu manipulieren.

Eine der leistungsstärksten Funktionen von ControlNet ist die Möglichkeit, aus einem Gesichtsbild einen gesamten Körper und seine Umgebung zu erstellen. Dies erfolgt durch die Verwendung des Plus-Gesichtsmodells und eines zweiten ControlNet-Bildes in der offenen Pose. Mit dieser Funktion können Benutzer den Winkel des Körpers und des Gesichts des Motivs besser steuern und so realistischere und detailliertere Bilder erstellen. Um mehr über ControlNet und seine Installation zu erfahren, besuchen Sie die Stability AI-Website.

Lesen Sie mehr Anleitung:

- Erstellen Sie KI-Kunstwerke mit Stable Diffusion, ComfyUI und mehreren ControlNet-Modellen

- Leonardo Ai Alchemy 2 und neue benutzerdefinierte SDXL-Modelle angekündigt

- Der Stability AI SDXL-Turbo AI-Kunstgenerator ist jetzt für die Echtzeitsynthese verfügbar.

- So erstellen Sie stabile Video-Streaming-Videos mit ComfyUI

- Verwendung von SDXL Turbo zur schnellen Generierung lokaler KI-Bilder und -Zeichnungen

- Wie fügt man sein Gesicht für Fotorealismus, Illustrationen und mehr in KI-Bilder ein?