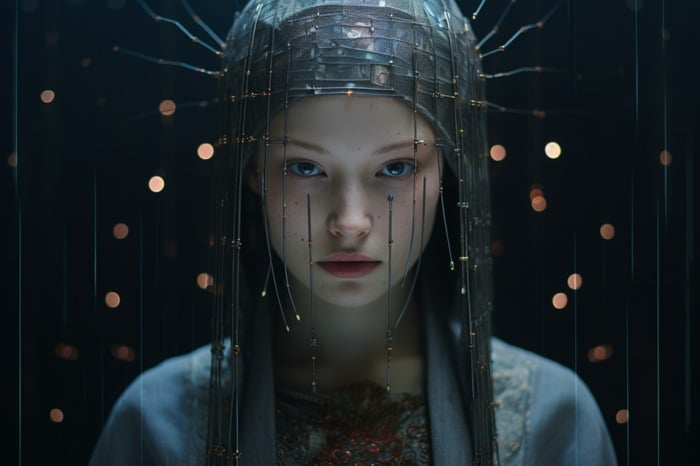

AI-artister som letar efter ett sätt att mer exakt kontrollera AI-konstskapandet inom stabil streaming kan vara intresserade av att lära sig hur man använder ControlNet. En stabil leveransmodell som har förändrat sättet AI-artister kan generera och manipulera bilder. Denna modell tillåter användare att kopiera mänskliga kompositioner eller poser från en referensbild, vilket ger en precisionsnivå som tidigare var ouppnåelig. Den här artikeln fördjupar sig i krångligheterna med att använda ControlNet, med fokus på Image Prompt Adapter och hur den kan användas för att anpassa AI-bilder.

ControlNet är en neural nätverksmodell designad för att kontrollera stabila diffusionsmönster. Det lägger till ett extra lager av konditionering till textprompten, vilket är den mest grundläggande formen för att använda SDXL-mallar. Denna ytterligare konditionering kan ta olika former, vilket gör det möjligt för användare att exakt manipulera AI-genererade bilder. Bildpromptadaptern i ControlNet är ett kraftfullt verktyg som kan användas för att skapa en person och bakgrund runt ett AI-genererat ansikte, ändra ålder, hårtyp och färg på en person i ett foto eller modifiera element i digital konst.

Hur använder man AI-konstpersonalisering med SDXL och ControlNet?

ControlNet och dess bildpromptadapter är ett kraftfullt verktyg för att manipulera och generera AI-bilder. Oavsett om du modifierar digital konst, återskapar AI-bilder eller skapar en hel kropp och miljö från en ansiktsbild, ger ControlNet en nivå av precision och kontroll som är otillgänglig. Med rätt kunskap och verktyg är möjligheterna till bildmanipulation och generering praktiskt taget obegränsade.

Se den här videon på YouTube.

Andra artiklar om ämnet Stable Diffusion skapade av Stability AI kan intressera dig:

- Stabil Diffusion SDXL Automatic 1111-verktyg och GUI

- Juggernaut XL AI art generator baserad på Stable Diffusion SDXL 1.0

- Hur man använder stabil diffusion för att byta ansiktsbilder för konsistens

- Hur man skapar konsekventa karaktärer i Stable Diffusions AI Art

- Hur installerar man Stable Diffusion SDXL 1.0 text-to-image AI art?

- Förbättrad prestanda för Stable Diffusion XL NVIDIA TensorRT

För att använda ControlNet måste användare ladda ner tre Hugging Face IP-adaptermallar, samt IP-adaptern plus ansiktsmallen. IP-adaptermallen är en bildpromptmall för text-till-bild-streaming-modeller såsom Stable Broadcast och kan användas i kombination med andra ControlNet-modeller.

Arbetsflödet för att använda IP-adaptermodellen innebär att man regenererar en AI-referensbild i SDXL och lägger till element till den slutliga bilden med hjälp av positiva uppmaningar. Denna process tillåter användare att modifiera element i digital konst med ControlNet. Användare kan till exempel använda inpainting för att modifiera håret på en basbild av AI och måla ansiktet på en annan basbild. Denna teknik ger en nivå av kontroll över vinkeln på motivets kropp och ansikte, vilket gör det möjligt för användare att byta motiv på en bild utan att ta till målning.

ControlNet-modeller kan även användas i kombination med andra modeller. Till exempel kan den animerade kontrollpunkten Rev användas för att ta en AI-genererad vektor av ett hus och återskapa den som animerad konst. Denna teknik kan användas för att manipulera konst i olika miljöer och väderförhållanden.

En av de mest kraftfulla funktionerna i ControlNet är möjligheten att skapa en hel kropp och miljö från en ansiktsbild. Detta görs genom att använda plusface-modellen och en andra ControlNet-bild med den öppna posen. Denna funktion tillåter användare att bättre kontrollera vinkeln på motivets kropp och ansikte, vilket gör att de kan skapa mer realistiska och detaljerade bilder. För att lära dig mer om ControlNet och hur man installerar det, besök Stability AI-webbplatsen.

Läs mer Guide:

- Skapa AI-konstverk med Stable Diffusion, ComfyUI och flera ControlNet-modeller

- Leonardo Ai Alchemy 2 och nya anpassade SDXL-modeller tillkännages

- Stability AI SDXL-Turbo AI art generator är nu tillgänglig för realtidssyntes.

- Hur man skapar stabila videoströmmande videor med ComfyUI

- Använder SDXL Turbo för snabb generering av lokala AI-bilder och ritningar

- Hur lägger du till ditt ansikte i AI-bilder för fotorealism, illustrationer och mer?