AI-artister som leter etter en måte å mer presist kontrollere AI-kunstskaping innen stabil streaming, kan være interessert i å lære å bruke ControlNet. En stabil leveringsmodell som har forvandlet måten AI-artister kan generere og manipulere bilder på. Denne modellen lar brukere kopiere menneskelige komposisjoner eller positurer fra et referansebilde, og gir et presisjonsnivå som tidligere var uoppnåelig. Denne artikkelen fordyper seg i vanskelighetene ved å bruke ControlNet, med fokus på Image Prompt Adapter, og hvordan den kan brukes til å tilpasse AI-bilder.

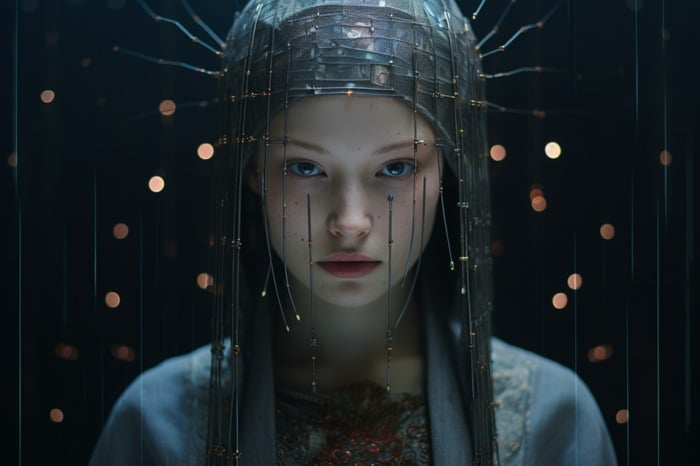

ControlNet er en nevrale nettverksmodell designet for å kontrollere stabile diffusjonsmønstre. Det legger til et ekstra lag med kondisjonering til tekstmeldingen, som er den mest grunnleggende formen for bruk av SDXL-maler. Denne ekstra kondisjoneringen kan ha forskjellige former, slik at brukere kan manipulere AI-genererte bilder nøyaktig. Image Prompt Adapter i ControlNet er et kraftig verktøy som kan brukes til å lage en person og bakgrunn rundt et AI-generert ansikt, endre alder, hårtype og farge på en person i et bilde, eller endre elementer i digital kunst.

Hvordan bruke AI-kunsttilpasning med SDXL og ControlNet?

ControlNet og dets Image Prompt Adapter gir et kraftig verktøy for å manipulere og generere AI-bilder. Enten du modifiserer digital kunst, regenererer AI-bilder eller skaper en hel kropp og et miljø fra et ansiktsbilde, gir ControlNet et nivå av presisjon og kontroll som er så langt utilgjengelig. Med riktig kunnskap og verktøy er mulighetene for bildemanipulering og generering praktisk talt ubegrensede.

Se denne videoen på YouTube.

Andre artikler om emnet Stable Diffusion laget av Stability AI kan interessere deg:

- Stabil diffusjon SDXL Automatic 1111 verktøy og GUI

- Juggernaut XL AI kunstgenerator basert på Stable Diffusion SDXL 1.0

- Hvordan bruke stabil diffusjon for å bytte ansiktsbilder for konsistens

- Hvordan lage konsistente karakterer i stabil diffusjons kunstig intelligens

- Hvordan installerer jeg Stable Diffusion SDXL 1.0 tekst-til-bilde AI-kunst?

- Forbedret ytelse av Stable Diffusion XL NVIDIA TensorRT

For å bruke ControlNet må brukerne laste ned tre Hugging Face IP-adaptermaler, samt IP-adapteren pluss ansiktsmalen. IP Adapter-malen er en bildemeldingsmal for tekst-til-bilde-streaming-modeller som Stable Broadcast og kan brukes i kombinasjon med andre ControlNet-modeller.

Arbeidsflyten for bruk av IP-adaptermodellen innebærer å regenerere et referanse-AI-bilde i SDXL og legge til elementer i det endelige bildet ved hjelp av positive spørsmål. Denne prosessen lar brukere endre elementer i digital kunst ved hjelp av ControlNet. For eksempel kan brukere bruke inpainting til å modifisere håret på et grunnleggende AI-bilde og male ansiktet til et annet basisbilde. Denne teknikken gir et nivå av kontroll over vinkelen på motivets kropp og ansikt, slik at brukere kan endre motivet til et bilde uten å ty til maling.

ControlNet-modeller kan også brukes i kombinasjon med andre modeller. For eksempel kan det animerte sjekkpunktet Rev brukes til å ta en AI-generert vektor av et hus og regenerere det som animert kunst. Denne teknikken kan brukes til å manipulere kunst i ulike miljøer og værforhold.

En av de kraftigste funksjonene til ControlNet er muligheten til å lage en hel kropp og et miljø fra et ansiktsbilde. Dette gjøres ved å bruke pluss-ansiktsmodellen og et andre ControlNet-bilde ved å bruke den åpne posituren. Denne funksjonen lar brukerne bedre kontrollere vinkelen på motivets kropp og ansikt, slik at de kan lage mer realistiske og detaljerte bilder. For å lære mer om ControlNet og hvordan du installerer det, besøk Stability AI-nettstedet.

Les mer guide:

- Lag kunstig kunstverk med stabil diffusjon, ComfyUI og flere ControlNet-modeller

- Leonardo Ai Alchemy 2 og nye tilpassede SDXL-modeller annonsert

- Stability AI SDXL-Turbo AI kunstgenerator er nå tilgjengelig for sanntidssyntese.

- Hvordan lage stabile videostreamingvideoer ved hjelp av ComfyUI

- Bruker SDXL Turbo for rask generering av lokale AI-bilder og tegninger

- Hvordan legge til ansiktet ditt i AI-bilder for fotorealisme, illustrasjoner og mer?