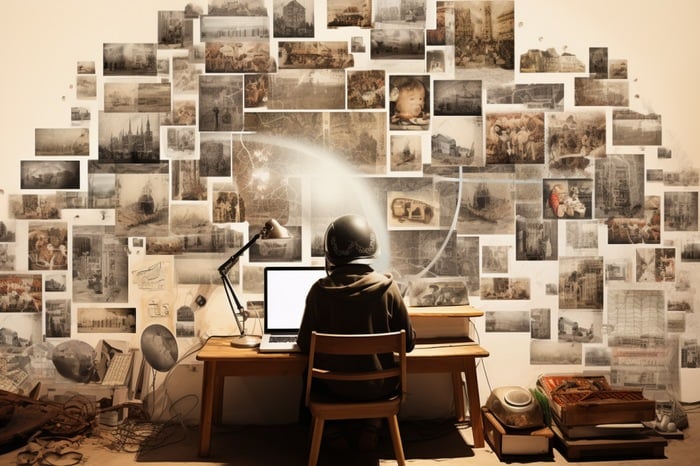

La dernière innovation d’OpenAI, le modèle ChatGPT-4 Vision, est un outil révolutionnaire capable d’analyser des images. Cette nouvelle fonctionnalité permet aux utilisateurs de télécharger une image et de poser des questions à son sujet, le modèle d’IA analysant l’image et répondant en conséquence. Les applications de cette technologie sont vastes, allant de la traduction linguistique à la résolution de problèmes mécaniques, en passant par l’analyse de données et de graphiques, et même la résolution de problèmes mathématiques ou de puzzles.

L’une des caractéristiques les plus impressionnantes de la dernière technologie apportée par OpenAI à son modèle d’IA ChatGPT est sa capacité à analyser et à décrire des photographies, en fournissant des descriptions détaillées, en reconnaissant et en décrivant des objets et même des personnes qui s’y trouvent. Cependant, il est important de noter que, bien qu’elle puisse reconnaître des individus spécifiques, elle ne spéculera pas sur les caractéristiques personnelles ou ne portera pas de jugements subjectifs. En outre, il est programmé pour ne pas identifier des personnes réelles sur la base d’images, ce qui garantit le respect de la vie privée et des considérations éthiques.

La capacité du modèle d’IA à reconnaître et à décrire des objets et des personnes dans des images ne se limite pas aux objets statiques ou aux visages. Il peut également analyser et comprendre l’humour des mèmes, ce qui ajoute une nouvelle dimension à ses capacités. Cette fonction pourrait être particulièrement utile dans le cadre de la surveillance des médias sociaux ou du marketing numérique, où la compréhension du contexte et de l’humour des mèmes est cruciale.

Utiliser OpenAI ChatGPT Vision pour analyser des images

Une autre fonction utile de GPT-4 Vision est sa capacité à traduire du texte dans des images. Cela peut s’avérer particulièrement important pour les utilisateurs qui rencontrent des textes dans une langue étrangère qu’ils ne comprennent pas. Il suffit de prendre une photo avec son téléphone et de la télécharger sur ChatGPT pour que le modèle d’IA puisse la traduire, ce qui permet d’éliminer les barrières linguistiques et de rendre l’information plus accessible.

ChatGPT-4 Vision a également des applications pratiques dans la cuisine. Elle peut suggérer des repas en se basant sur des images d’aliments dans un réfrigérateur. En analysant le contenu d’un réfrigérateur, elle peut générer des recettes détaillées, aidant les utilisateurs à tirer le meilleur parti des ingrédients qu’ils ont sous la main. Cette fonction pourrait changer la donne pour ceux qui ont du mal à planifier leurs repas ou qui souhaitent réduire le gaspillage alimentaire.

Les capacités de ChatGPT-4 Vision s’étendent à la collaboration avec DallE 3, un autre modèle d’IA. Il peut fournir un retour d’information sur les images générées par DallE 3 et suggérer des améliorations, créant ainsi une relation synergique entre les deux modèles d’IA. Cela pourrait permettre d’obtenir de meilleurs résultats au fil du temps, car les modèles d’IA apprennent l’un de l’autre et améliorent leurs capacités. OpenAI en dit un peu plus sur la carte système GPT-4V(ision).

GPT-4V(ision)

« La carte GPT-4 avec vision (GPT-4V) permet aux utilisateurs de demander à la carte GPT-4 d’analyser les images fournies par l’utilisateur, et c’est la dernière capacité que nous rendons largement disponible. L’intégration de modalités supplémentaires (telles que les entrées d’images) dans les grands modèles de langage (LLM) est considérée par certains comme une frontière essentielle dans la recherche et le développement de l’intelligence artificielle.

Les LLM multimodaux offrent la possibilité d’étendre l’impact des systèmes uniquement linguistiques avec de nouvelles interfaces et capacités, leur permettant de résoudre de nouvelles tâches et d’offrir de nouvelles expériences à leurs utilisateurs. Dans cette carte système, nous analysons les propriétés de sécurité du GPT-4V. Notre travail sur la sécurité du GPT-4V s’appuie sur le travail effectué pour le GPT-4 et nous approfondissons ici les évaluations, la préparation et le travail d’atténuation effectué spécifiquement pour les entrées d’images ».

Malgré ses capacités impressionnantes, il est important de noter que le GPT-4 Vision est conçu dans le respect de la vie privée. Il ne peut pas stocker, mémoriser ou accéder à des images antérieures, ce qui garantit que les données des utilisateurs ne sont pas compromises. Il peut fournir des descriptions générales sur les attributs visuels des personnes, mais il n’identifiera pas la personne, gardant ainsi une distance respectueuse par rapport à l’identification personnelle.

Le modèle de vision ChatGPT-4 d’OpenAI est un outil puissant qui peut analyser les images de diverses manières. Qu’il s’agisse de traduire du texte dans des images, de suggérer des repas en fonction du contenu du réfrigérateur, de comprendre l’humour dans les mèmes ou de fournir un retour sur des images générées par DallE 3, les applications de cette technologie sont vastes. Au fur et à mesure de son déploiement auprès des abonnés, il est clair que ce modèle d’IA a le potentiel de révolutionner la façon dont nous interagissons avec les images.

Lire plus Guide:

- Comment télécharger des images sur ChatGPT pour les analyser ?

- Analyse et création d’images dans ChatGPT DallE 3

- 80+ ChatGPT-4 Les fonctions de vision et les applications du monde réel explorées

- Plus de 100 applications et cas d’utilisation possibles de ChatGPT Vision

- Comment utiliser ChatGPT Vision – Guide du débutant

- 7 façons d’utiliser le mode Vision de ChatGPT