Hvis du, som meg, ble litt skuffet over å høre at Google Gemini-demoen, publisert tidligere denne måneden, var mer en smart redigering enn et teknologisk fremskritt. Du vil gjerne vite at vi kanskje ikke trenger å vente for lenge før noe lignende blir tilgjengelig.

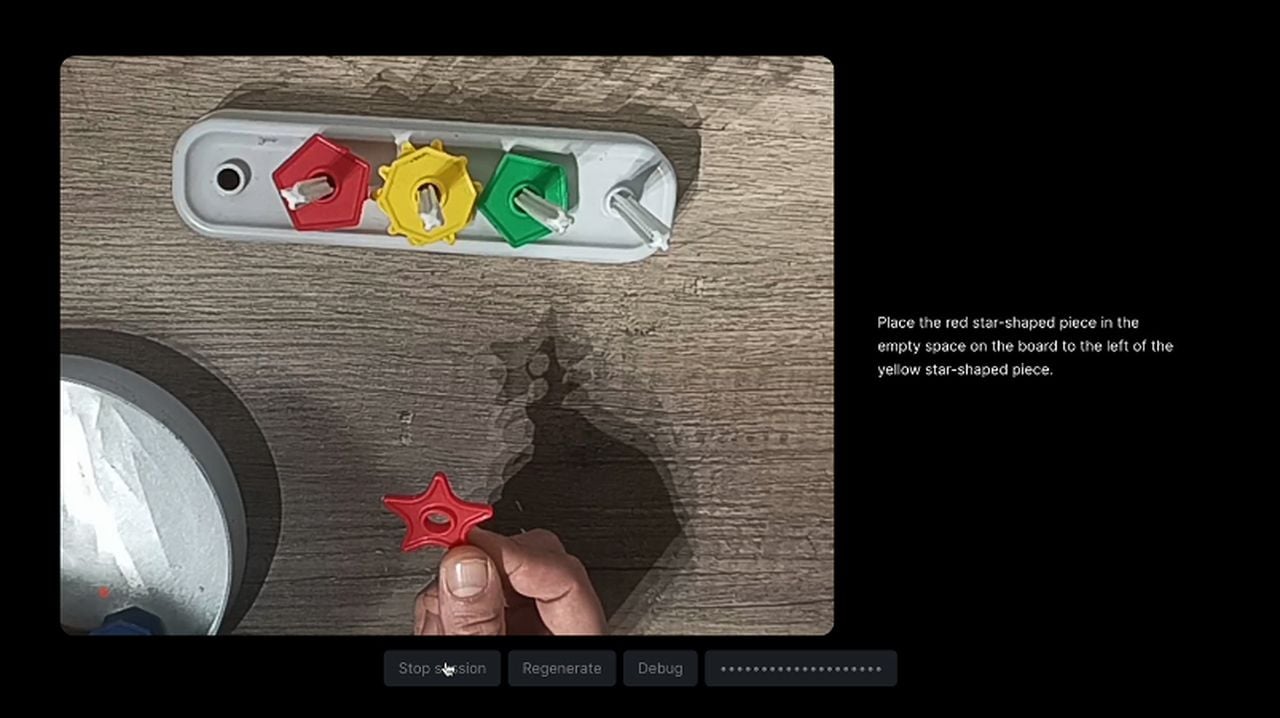

Etter å ha sett demonstrasjonen av Google Gemini og avsløringen av bloggartikkelen som avslører dens hemmeligheter. spurte Julien De Luca seg selv hvis Gemini-eksperimentet presentert av Google kunne være mer enn en enkel skriptdemonstrasjon. Deretter laget han et morsomt eksperiment for å utforske muligheten for sanntids AI-interaksjoner som ligner på de som er vist i Gemini-demoen. Her er noen begrensninger han la på prosjektet for å holde det konsistent med Googles originale demo.

- Prosjektet skal skje i sanntid

- Brukeren må kunne kringkaste en video

- Brukeren skal kunne snakke med assistenten uten å samhandle med brukergrensesnittet.

- Assistenten skal bruke videodataene til å svare på brukerens spørsmål.

- Assistenten skal svare ved å snakke.

På grunn av Chat GPT Visions nåværende evne til å bare godta individuelle bilder, De Luca måtte laste opp en serie bilder og skjermbilder fra videoen med jevne mellomrom for at GPT skulle forstå hva som skjedde .

"KABOOM! Vi har nå et enkelt bilde som representerer en videostrøm. Nå snakker vi. Jeg måtte justere systemmeldingen for å få den til å "forstå" at det var en video. Ellers fortsatte han å nevne «mønstre», «strips» eller «grids». Jeg insisterte også på bildenes temporalitet, slik at han resonnerer ved å bruke bildesekvensen. Dette systemet kan definitivt forbedres, men for denne opplevelsen fungerer det bra nok.", forklarer Mr. De Luca. For å lære mer om denne prosessen, besøk Crafters.ai-nettstedet eller GitHub.

Opprette en ekte Google Gemini-demo

AI Jason laget også et eksempel som kombinerer GPT-4, Whisper og Text-to-Speech (TTS) teknologier. Se videoen nedenfor for en demonstrasjon og for å lære mer om hvordan du lager et eksempel selv ved å bruke forskjellige AI-teknologier kombinert sammen.

For å lage en demo som emulerer den originale Gemini med GPT-4V, Whisper og TTS-integrasjon, legger utviklerne ut på en kompleks teknisk reise. Denne prosessen begynner med å sette opp et Next.js-prosjekt, som fungerer som grunnlag for integrering av funksjoner som videoopptak, lydtranskripsjon og generering av bilder. Implementering av API-kall til OpenAI er avgjørende fordi det lar AI delta i en samtale med brukere, svare på spørsmålene deres og gi svar i sanntid.

Brukeropplevelsesdesign er kjernen i demoen, med fokus på å skape et intuitivt grensesnitt som muliggjør naturlige interaksjoner med AI, som om det var en samtale med et annet menneske. Disse inkluderer evnen til AI til å forstå visuelle signaler og svare på dem på riktig måte.

Å gjenoppbygge Gemini-demoen med GPT-4V, Whisper og Text-To-Speech er en klar indikasjon på fremgang mot en fremtid der AI kan forstå og samhandle med oss gjennom flere sanser. Denne utviklingen lover å tilby en mer naturlig og oppslukende opplevelse. Fortsatt bidrag og innsikt fra AI-fellesskapet vil være avgjørende for å forme fremtiden til multimodale applikasjoner.

Fotokreditt: Julien De Luca