Le domaine de l’intelligence artificielle vient d’accueillir un nouveau grand modèle linguistique d’intelligence artificielle (IA) sous la forme de NeuralBeagle14-7B. Ce modèle d’IA avancé fait des vagues avec ses 7 milliards de paramètres, et il a rapidement gravi les échelons pour devenir un concurrent de premier plan parmi les grands modèles de langage.

NeuralBeagle n’est pas un modèle comme les autres ; c’est un hybride, créé en combinant les meilleures caractéristiques de deux modèles existants, Beagle et Mar Coro. Cette fusion a été encore améliorée par une technique unique appelée Lazy Merge Kit. NeuralBeagle14-7B est un ajustement DPO de mlabonne/Beagle14-7B utilisant l’ensemble de données de préférence argilla/distilabel-intel-orca-dpo-pairs.

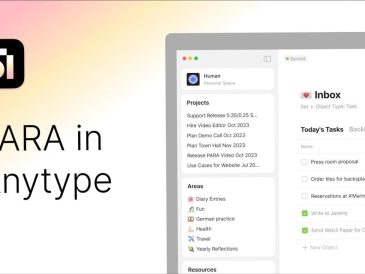

Mergekit est une boîte à outils permettant de fusionner des modèles de langage pré-entraînés. Mergekit utilise une approche hors cœur pour réaliser des fusions déraisonnablement élaborées dans des situations où les ressources sont limitées. Les fusions peuvent être exécutées entièrement sur le processeur ou accélérées avec seulement 8 Go de VRAM. De nombreux algorithmes de fusion sont pris en charge, et d’autres sont en cours d’élaboration.

Le succès de NeuralBeagle repose sur les performances élevées du modèle Beagle, qui avait déjà démontré ses capacités en obtenant de bons résultats dans un tableau de classement bien connu sur l’IA. En intégrant Beagle à Mar Coro, les développeurs ont créé un modèle puissant qui tire parti des forces des deux. Mais l’équipe ne s’est pas arrêtée là. Elle a également appliqué un processus d’affinage connu sous le nom de « Domain Preferred Option » (DPO). Bien que cette mise au point n’ait pas permis d’améliorer radicalement les performances du modèle, elle a fourni des informations importantes sur le processus de mise au point et ses effets sur les modèles d’IA.

NeuralBeagle14-7B

NeuralBeagle se distingue par sa polyvalence. Il a été rigoureusement testé sur diverses plateformes, notamment AGI Evol et GPT-4-All, démontrant ainsi sa capacité à exécuter un large éventail de tâches. Cette adaptabilité témoigne de la conception sophistiquée du modèle et de ses possibilités d’utilisation dans différentes applications. NeuralBeagle14-7B utilise une fenêtre contextuelle de 8k. Il est compatible avec différents modèles, comme chatml et le modèle de chat de Llama. NeuralBeagle14-7B est classé premier sur le Open LLM Leaderboard dans la catégorie ~7B.

Pour ceux qui souhaitent voir NeuralBeagle en action, le modèle est disponible à l’essai sur Hugging Face Spaces. Cette plateforme interactive permet aux utilisateurs de s’engager directement avec NeuralBeagle et de voir comment il fonctionne. Et pour ceux qui souhaitent intégrer NeuralBeagle dans leurs propres projets, il existe des instructions d’installation détaillées pour LM Studio, ce qui facilite la mise en route.

NeuralBeagle représente une avancée significative dans le monde des modèles d’IA open-source. Sa combinaison innovante de deux modèles et l’exploration du réglage fin de l’OPD donnent un aperçu de l’évolution actuelle de l’IA. Le modèle est désormais à la disposition des chercheurs, des développeurs et des passionnés d’IA, qui peuvent le tester et l’intégrer dans leur travail. Avec des options de test en ligne et d’installation locale, NeuralBeagle est en passe de devenir un outil précieux pour la communauté de l’IA.

Crédit image mlabonne

Lire plus Guide:

- Comparaison des modèles Llama 2 70B et Zephyr-7B LLM

- Nouveau Mixtral 8x22B MoE, puissant modèle de langue à source ouverte (LLM)

- L’IA open source Google Gemma optimisée pour fonctionner sur les GPU NVIDIA

- Lancement du nouvel assistant de codage d’IA open source DeepSeek

- Le petit modèle linguistique Orca-2 13B de Microsoft surpasse les alternatives 70B

- OpenAI annonce des changements de prix pour ChatGPT, des modèles d’intégration et des mises à jour de l’API