Meta AI a présenté cette semaine ses nouvelles puces d’accélération de la formation et de l’inférence de l’IA de nouvelle génération. Avec la demande de modèles d’IA sophistiqués qui monte en flèche dans tous les secteurs, les entreprises auront besoin d’une infrastructure informatique puissante et fiable pour suivre le rythme. L’accélérateur de Meta pourrait être la réponse, en fournissant aux applications d’entreprise les outils nécessaires pour s’attaquer facilement aux charges de travail d’IA les plus complexes. Avec plus du double de la bande passante de calcul et de mémoire de son prédécesseur, cette technologie innovante est conçue pour optimiser les modèles de classement et de recommandation, garantissant que vous pouvez fournir un contenu personnalisé et de haute qualité à vos utilisateurs à des vitesses fulgurantes.

L’année dernière, Meta a dévoilé le Meta Training and Inference Accelerator (MTIA) v1, son accélérateur d’inférence d’IA de première génération que nous avons conçu en interne avec les charges de travail d’IA de Meta à l’esprit – en particulier les modèles de recommandation d’apprentissage profond de Meta qui améliorent une variété d’expériences à travers la gamme de produits de l’entreprise.

Principaux enseignements

- Meta a partagé des détails sur la nouvelle génération du Meta Training and Inference Accelerator (MTIA), sa famille de puces personnalisées conçues pour les charges de travail d’IA de Meta.

- Cette dernière version présente des améliorations significatives en termes de performances par rapport à MTIA v1 et contribue à alimenter les modèles publicitaires de classement et de recommandation de Meta.

- MTIA fait partie de l’investissement croissant de Meta dans notre infrastructure d’IA et complétera notre infrastructure d’IA existante et future pour offrir de nouvelles et meilleures expériences à travers ses produits et services.

L’impact de l’accélérateur d’IA de nouvelle génération de Meta va bien au-delà du domaine des possibilités théoriques. En explorant le vaste potentiel de cette technologie, vous découvrirez qu’elle fait déjà des vagues dans des applications réelles. Déployé dans des centres de données du monde entier, l’accélérateur alimente des modèles prêts à la production, démontrant ainsi sa capacité à répondre aux exigences du monde actuel axé sur l’IA.

Bien que les détails de la tarification restent confidentiels, l’importance de cette innovation ne peut être surestimée. L’engagement de Meta à repousser les limites de l’informatique de l’IA est évident dans la disponibilité de l’accélérateur et sa préparation au déploiement. Alors que vous vous lancez dans votre propre voyage en matière d’IA, vous pouvez être sûr que la technologie de Meta sera là pour vous soutenir à chaque étape.

Une plongée en profondeur dans les spécifications

Pour vraiment apprécier les capacités de l’accélérateur d’IA de nouvelle génération de Meta, il est essentiel d’explorer ses spécifications impressionnantes :

- Une technologie de pointe : Construit sur le processus TSMC 5nm, garantissant des performances et une efficacité optimales.

- Fréquence impressionnante : Fonctionnant à 1,35 GHz, il permet des calculs rapides comme l’éclair.

- Instances robustes : Avec 2,35 milliards de portes et 103 millions de flops, elles offrent des ressources suffisantes pour les modèles d’intelligence artificielle complexes.

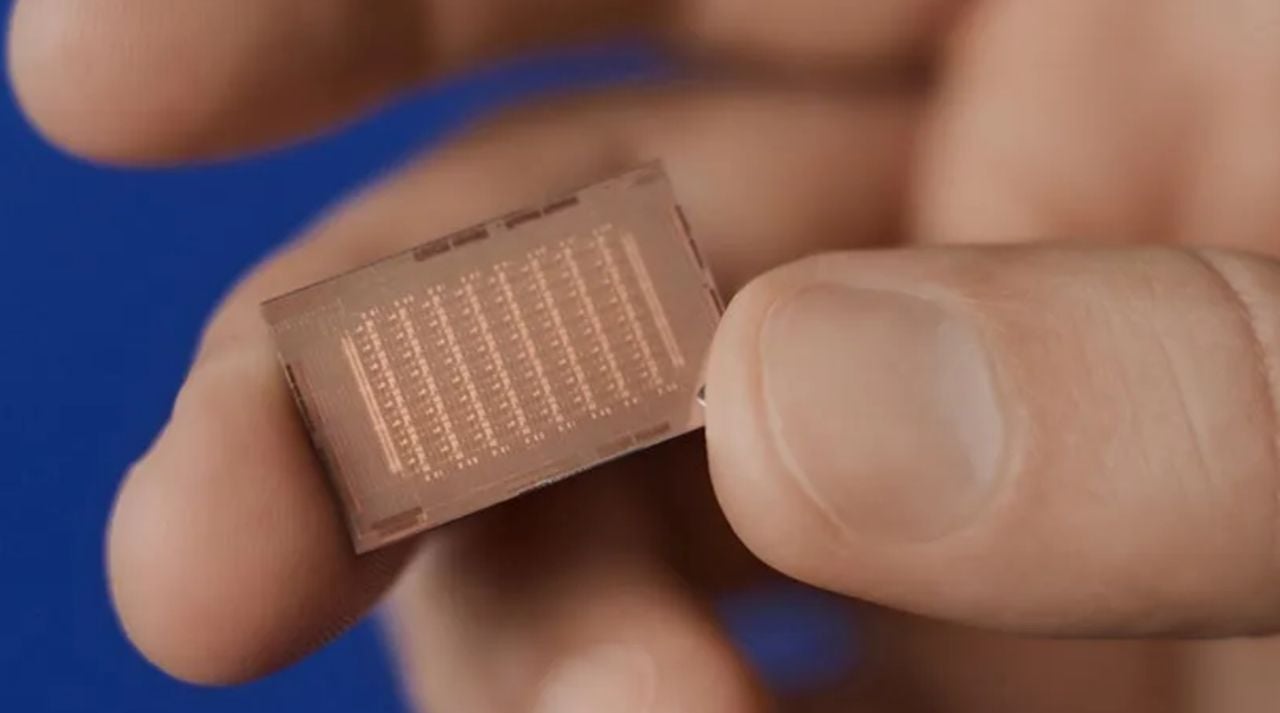

- Conception compacte : Mesurant seulement 25,6 mm x 16,4 mm, avec une surface totale de 421 mm2, il est idéal pour les environnements où l’espace est limité.

- Emballage efficace : Logé dans un boîtier de 50 mm x 40 mm, il assure une gestion thermique et une fiabilité optimales.

- Fonctionnement à basse tension : Fonctionnant à 0,85 V, il minimise la consommation d’énergie sans compromettre les performances.

- Puissance thermique nominale (TDP) : 90 W, pour un équilibre parfait entre performances et efficacité énergétique.

- Connexion hôte à grande vitesse : Équipé de 8x PCIe Gen5, offrant une bande passante de 32 Go/s pour un transfert de données transparent.

- GEMM TOPS inégalé : Jusqu’à 708 TFLOPS/s (INT8) avec sparsité, permettant des multiplications matricielles rapides comme l’éclair.

- Des TOP SIMD impressionnants : Offre jusqu’à 11,06 TFLOPS/s (INT8), facilitant les opérations vectorielles efficaces.

- Capacité de mémoire étendue : Avec 384 Ko de mémoire locale par PE, 256 Mo sur la puce et 128 Go hors puce LPDDR5, le stockage est largement suffisant pour les modèles d’IA les plus exigeants.

- Bande passante mémoire exceptionnelle : 1 TB/s de mémoire locale par PE, 2,7 TB/s sur la puce et 204,8 GB/s hors puce LPDDR5, garantissant un accès et un traitement rapides des données.

Embrasser la révolution de l’IA

L’accélérateur de nouvelle génération de Meta est votre porte d’entrée vers des possibilités infinies et n’est que le début d’un voyage passionnant qui remodèlera les industries et redéfinira la façon dont nous interagissons avec les machines. De l’IA générative à la recherche avancée, les applications de cet accélérateur sont illimitées. L’engagement inébranlable de Meta à repousser les limites de l’informatique de l’IA, grâce au silicium personnalisé, à la bande passante de la mémoire et à la capacité de mise en réseau, garantit que vous aurez toujours accès aux outils et aux ressources les plus avancés.

Lire plus Guide:

- Exécution locale de Llama 2 sur les Apple M3 Silicon Macs

- Présentation complète de l’événement Intel AI Everywhere

- La puce d’intelligence artificielle la plus rapide du monde compte 4 billions de transistors et 900 000 cœurs d’intelligence artificielle

- La puce DEEPX DX-M1 conçue pour les applications de l’IA des objets

- Nouveau Apple MacBook Pro M3 14 pouces à partir de 1 599

- Meta stocke de puissants GPU NVIDIA pour le développement de l’AGI