Fremkomsten af kunstig intelligens og maskinlæring har transformeret en lang række områder, herunder naturlig sprogbehandling. Et af de vigtigste fremskridt på dette område er udviklingen og frigivelsen af ChatGPT 3.5 Turbo, en sprogmodel udviklet af OpenAI. I denne vejledning tager vi et kig på processen med at automatisere GPT 3.5 Turbos finjustering til opkaldsfunktioner ved hjælp af Python, især med fokus på at bruge Llama-indekset.

OpenAI annoncerede finjustering af tilgængeligheden for sin GPT-3.5 Turbo-model i august 2023, med understøttelse af GPT-4 planlagt til efteråret. Denne nye funktion giver udviklere mulighed for at tilpasse sprogmodeller til bedre at imødekomme deres specifikke behov, hvilket forbedrer ydeevne og funktionalitet. Især har tidlige test vist, at en raffineret version af GPT-3.5 Turbo kan matche eller endda overgå basis GPT-4-modellen i specialiserede opgaver. Når det kommer til databeskyttelse, sikrer OpenAI, at alle data, der sendes til og fra finjusterings-API'en, forbliver kundens ejendom. Det betyder, at dataene ikke bruges af OpenAI eller nogen anden organisation til at træne andre modeller.

En af de vigtigste fordele ved at fokusere er forbedret orientering. Udviklere kan få modellen til at følge specifikke instruktioner mere effektivt. For eksempel kan modellen indstilles til altid at svare på et bestemt sprog, såsom tysk, når du bliver bedt om det. En anden fordel er konsekvent resultatformatering, som er afgørende for applikationer, der kræver et specifikt svarformat, såsom kodefuldførelse eller generering af API-opkald. Udviklere kan finjustere modellen for pålideligt at generere JSON-uddrag af høj kvalitet baseret på brugerprompts.

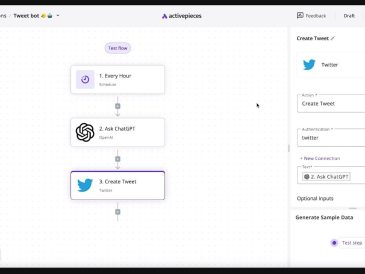

Hvordan automatiserer man ChatGPT finjustering?

Automatisering af udviklingen af GPT 3.5 Turbo involverer en række trin, startende med generering af dataklasser og eksempler. Denne proces er skræddersyet til brugerens specifikke use case, hvilket sikrer, at den resulterende funktionsbeskrivelse og raffinerede model er egnet til formålet. Generering af dataklasser og eksempler lettes af en Python-fil, som er den første del af en sekvens på seks filer.

Den anden fil i sekvensen bruger Llama Index, et kraftfuldt værktøj, der automatiserer flere processer. Lama-indekset genererer et finjusterende datasæt baseret på den liste, der er produceret af den første fil. Dette datasæt er afgørende for yderligere forfining af GPT 3.5 Turbo-modellen. Det næste trin i sekvensen er at udtrække funktionsdefinitionen fra de genererede eksempler. Dette trin er vigtigt for at foretage opkald til den raffinerede model. Uden funktionsdefinitionen ville modellen ikke være i stand til at behandle forespørgsler effektivt.

Processen bruger Llama-indekset igen, denne gang til at forfine GPT 3.5 Turbo-modellen ved hjælp af det genererede datasæt. Finjusteringsprocessen kan styres fra Python-udviklingsmiljøet eller OpenAI Playground, hvilket giver brugerne fleksibilitet og kontrol over processen.

ChatGPT 3.5 Turbo-opdatering

Når modellen er blevet forfinet, kan den bruges til at foretage almindelige opkald til GPT-4, forudsat at funktionsdefinitionen er inkluderet i opkaldet. Denne egenskab gør det muligt for modellen at blive brugt i en lang række applikationer, fra besvarelse af komplekse forespørgsler til generering af menneskelignende tekst.

Kodefilerne til dette projekt er tilgængelige på præsentationsværtens Patreon-side, og giver brugerne de ressourcer, de har brug for til at automatisere finjusteringen af GPT 3.5 Turbo til deres specifikke brugssituationer. Foredragsholderens hjemmeside byder også på et væld af informationer med et omfattende bibliotek af videoer, som kan gennemses og søges efter yderligere råd.

Finjustering er mest effektiv, når den integreres med andre teknikker, såsom prompt engineering, informationssøgning og funktionskald. OpenAI indikerede også, at det vil udvide finjusteringsunderstøttelsen med funktionskald og en 16-tokens version af GPT-3.5 Turbo senere på efteråret. Samlet set tilbyder finjusteringsopdateringen til GPT-3.5 Turbo et alsidigt og robust funktionssæt til udviklere, der ønsker at tilpasse modellen til specialiserede opgaver. Med den kommende mulighed for at finjustere GPT-4-modeller forventes omfanget af at skabe meget personlige og effektive sprogmodeller at udvide sig yderligere.

Automatisering af Turbo GPT 3.5-finjustering til funktionskald ved hjælp af Python og Llama-indeks er en kompleks, men opnåelig proces. Ved at generere dataklasser og eksempler skræddersyet til brugerens anvendelsestilfælde, udnytte Llama-indekset til at automatisere processer og omhyggeligt udtrække funktionsdefinitioner, kan brugerne skabe en finjusteret model, der er i stand til at foretage regelmæssige opkald til GPT-4. Selvom denne proces er kompleks, giver den betydelige fordele, som giver brugerne mulighed for at udnytte kraften i GPT 3.5 Turbo til en bred vifte af applikationer.

Læs mere guide:

- Hvordan finjusterer man ChatGPT 3.5 Turbos AI-modeller til forskellige opgaver?

- Sådan forfines nemt Llama 2 LLM-modeller på kun 5 minutter

- Opbygning af avancerede AI-agenter og -assistenter ved hjælp af Python

- Ny Zephyr-7B LLM AI-model forfiner Mistral-7B og slår Llama-2 70B

- LLaMA Factory lader dig nemt forfine og træne store sprogmodeller (LLM).

- Kør Llama 2 Uncensored og andre LLM'er lokalt ved hjælp af Ollama for privatliv og sikkerhed