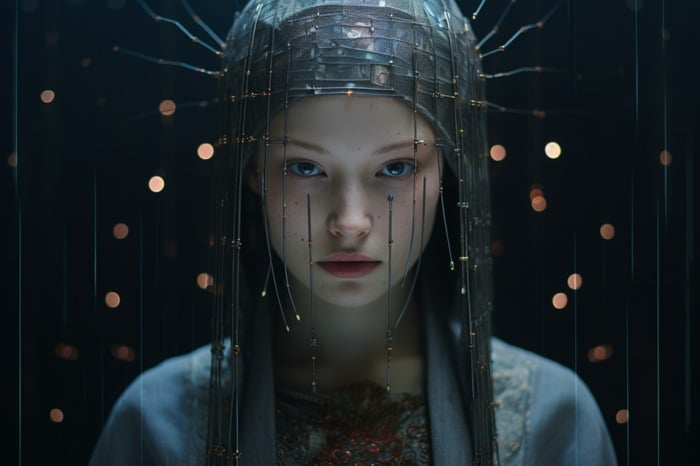

Les artistes de l’IA qui cherchent un moyen de contrôler plus précisément la création artistique de l’IA dans le cadre de la diffusion stable pourraient être intéressés par l’apprentissage de l’utilisation de ControlNet. Un modèle de diffusion stable qui a transformé la façon dont les artistes de l’IA peuvent générer et manipuler des images. Ce modèle permet aux utilisateurs de copier des compositions ou des poses humaines à partir d’une image de référence, offrant ainsi un niveau de précision jusqu’alors inaccessible. Cet article se penche sur les subtilités de l’utilisation de ControlNet, en se concentrant sur l’adaptateur d’invite d’image, et sur la manière dont il peut être utilisé pour personnaliser les images d’IA.

ControlNet est un modèle de réseau neuronal conçu pour contrôler les modèles de diffusion stable. Il ajoute une couche supplémentaire de conditionnement à l’invite textuelle, qui est la forme la plus basique d’utilisation des modèles SDXL. Ce conditionnement supplémentaire peut prendre différentes formes, permettant aux utilisateurs de manipuler avec précision les images générées par l’IA. L’adaptateur d’invite d’image dans ControlNet est un outil puissant qui peut être utilisé pour créer une personne et un arrière-plan autour d’un visage généré par l’IA, changer l’âge, le type de cheveux et la couleur d’une personne sur une photo, ou modifier des éléments dans l’art numérique.

Comment utiliser la personnalisation de l’art de l’IA avec SDXL et ControlNet ?

ControlNet et son adaptateur d’invite d’image constituent un outil puissant pour manipuler et générer des images d’IA. Qu’il s’agisse de modifier des éléments d’art numérique, de régénérer des images d’IA ou de créer un corps et un environnement entiers à partir d’une image de visage, ControlNet offre un niveau de précision et de contrôle jusqu’alors inaccessible. Avec les connaissances et les outils appropriés, les possibilités de manipulation et de génération d’images sont virtuellement illimitées.

Regardez cette vidéo sur YouTube.

D’autres articles sur le sujet Stable Diffusion créés par Stability AI peuvent vous intéresser :

- Stable Diffusion SDXL Automatic 1111 outils et GUI

- Générateur d’art Juggernaut XL AI basé sur Stable Diffusion SDXL 1.0

- Comment utiliser Stable Diffusion pour échanger des images de visage pour la cohérence

- Comment créer des personnages cohérents dans l’art AI de Stable Diffusion

- Comment installer Stable Diffusion SDXL 1.0 text-to-image AI art ?

- Amélioration des performances de Stable Diffusion XL NVIDIA TensorRT

Pour utiliser ControlNet, les utilisateurs doivent télécharger trois modèles d’adaptateurs IP de Hugging Face, ainsi que l’adaptateur IP plus le modèle de visage. Le modèle d’adaptateur IP est un modèle d’invite d’image pour les modèles de diffusion texte-image tels que la diffusion stable et peut être utilisé en combinaison avec d’autres modèles ControlNet.

Le flux de travail pour l’utilisation du modèle adaptateur IP implique la régénération d’une image AI de référence dans SDXL et l’ajout d’éléments à l’image finale à l’aide d’invites positives. Ce processus permet aux utilisateurs de modifier des éléments dans l’art numérique à l’aide de ControlNet. Par exemple, les utilisateurs peuvent utiliser l’inpainting pour modifier les cheveux d’une image AI de base et peindre le visage d’une autre image de base. Cette technique offre un niveau de contrôle sur l’angle du corps et du visage du sujet, ce qui permet aux utilisateurs de modifier le sujet d’une image sans avoir recours à l’inpainting.

Les modèles ControlNet peuvent également être utilisés en combinaison avec d’autres modèles. Par exemple, le point de contrôle animé Rev peut être utilisé pour prendre un vecteur d’une maison généré par l’IA et le régénérer sous forme d’art animé. Cette technique peut être utilisée pour manipuler l’art dans divers environnements et conditions météorologiques.

L’une des fonctions les plus puissantes de ControlNet est la possibilité de créer un corps et un environnement entiers à partir d’une image de visage. Pour ce faire, on utilise le modèle de visage plus et une deuxième image ControlNet utilisant la pose ouverte. Cette fonction permet aux utilisateurs de mieux contrôler l’angle du corps et du visage du sujet, ce qui leur permet de créer des images plus réalistes et plus détaillées. Pour en savoir plus sur ControlNet et sur la manière de l’installer, rendez-vous sur le site Web de Stability AI.

Lire plus Guide:

- Création d’œuvres d’art en IA avec Stable Diffusion, ComfyUI et plusieurs modèles ControlNet

- Leonardo Ai Alchemy 2 et nouveaux modèles SDXL personnalisés annoncés

- Le générateur d’art Stability AI SDXL-Turbo AI est désormais disponible pour la synthèse en temps réel.

- Comment créer des vidéos de diffusion vidéo stable à l’aide de ComfyUI

- Utilisation de SDXL Turbo pour la génération rapide d’images et de dessins d’IA locaux

- Comment ajouter votre visage dans des images AI pour un photoréalisme, des illustrations et bien plus encore ?