L’avènement de l’intelligence artificielle (IA) et sa croissance subséquente ont entraîné un changement important dans le paysage technologique. L’un des domaines qui subit cette transformation est l’informatique en nuage, où les réseaux en nuage traditionnels basés sur Ethernet sont mis au défi de gérer les exigences de calcul des charges de travail modernes de l’IA. Cette situation a conduit à l’émergence des SuperNIC, une nouvelle catégorie d’accélérateurs de réseau spécialement conçus pour améliorer les charges de travail d’IA dans les nuages basés sur Ethernet.

Les SuperNIC, ou Super Network Interface Cards, possèdent des caractéristiques uniques qui les distinguent des cartes d’interface réseau (NIC) traditionnelles. Il s’agit notamment de la réorganisation des paquets à grande vitesse, du contrôle avancé de la congestion, du calcul programmable sur le chemin des E/S, de la conception économe en énergie et de l’optimisation complète de l’IA. Ces caractéristiques sont conçues pour fournir une connectivité réseau à haut débit pour la communication GPU-GPU, avec des vitesses pouvant atteindre 400 Gb/s en utilisant la technologie RDMA sur RoCE.

Les capacités des SuperNICs sont particulièrement cruciales dans le paysage actuel de l’IA, où l’avènement de l’IA générative et des grands modèles de langage a imposé des demandes de calcul sans précédent. Les cartes Ethernet traditionnelles et les cartes réseau fondamentales, qui n’ont pas été conçues pour répondre à ces besoins, ont du mal à suivre. Les SuperNIC, en revanche, sont spécialement conçues pour ces charges de travail d’IA modernes, offrant un transfert de données efficace, une faible latence et des performances déterministes.

Qu’est-ce qu’un SuperNIC et pourquoi est-ce important ?

La comparaison entre les SuperNIC et les unités de traitement de données (DPU) est intéressante. Alors que les DPU offrent un débit élevé et une connectivité réseau à faible latence, les SuperNIC vont encore plus loin en étant spécifiquement optimisés pour accélérer les réseaux pour l’IA. Cette optimisation est évidente dans le rapport 1:1 entre les GPU et les SuperNIC au sein d’un système, un choix de conception qui améliore considérablement l’efficacité de la charge de travail de l’IA.

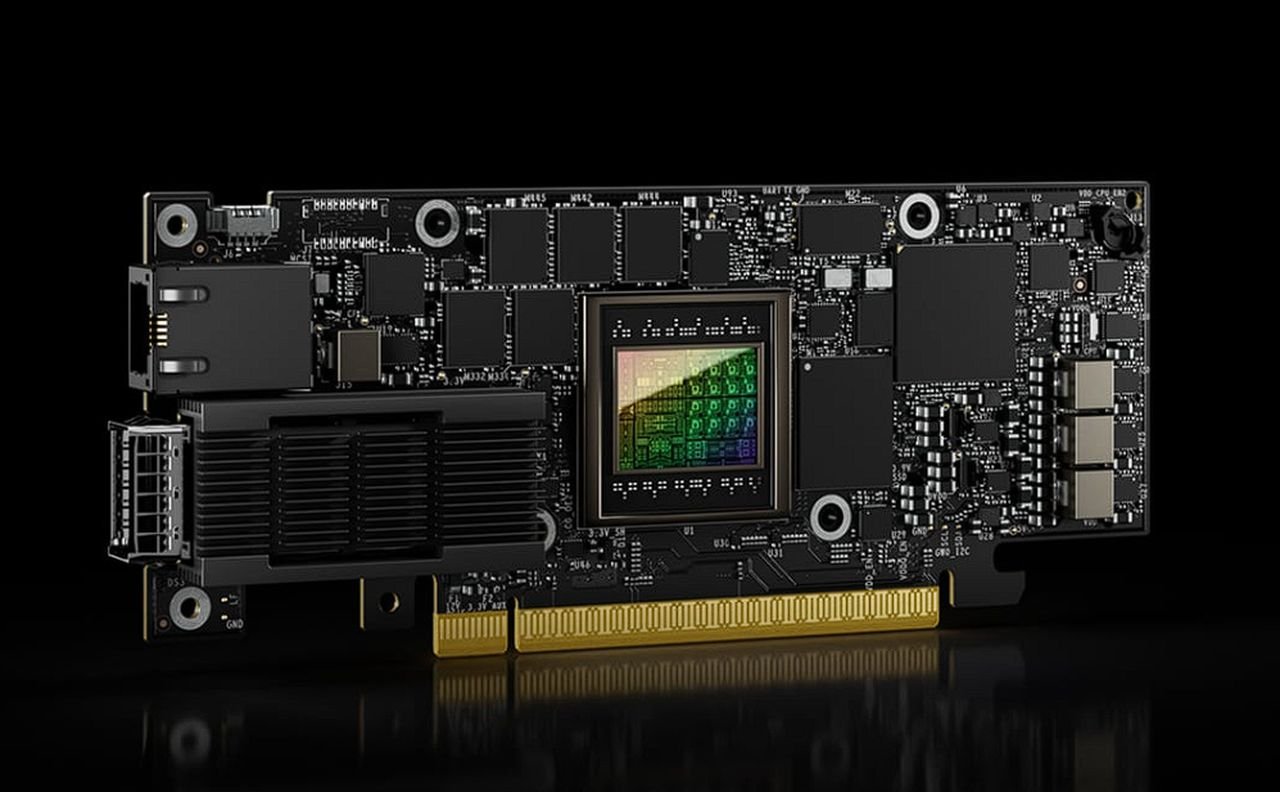

Le BlueField-3 SuperNIC de NVIDIA, premier SuperNIC au monde pour l’informatique de l’IA, est un excellent exemple de cette nouvelle technologie. Basé sur la plate-forme réseau BlueField-3 et intégré au système de commutation Ethernet Spectrum-4, ce SuperNIC fait partie d’une structure informatique accélérée conçue pour optimiser les charges de travail d’IA.

Le SuperNIC NVIDIA BlueField-3 offre plusieurs avantages qui en font un atout précieux dans les environnements informatiques d’IA. Il offre une efficacité maximale des charges de travail d’IA, des performances constantes et prévisibles et une infrastructure de cloud multi-tenant sécurisée. En outre, il offre une infrastructure réseau extensible et une large prise en charge des fabricants de serveurs, ce qui en fait une solution polyvalente pour répondre à divers besoins en matière d’IA.

L’émergence des SuperNICs marque une étape importante dans l’évolution de l’informatique en nuage de l’IA. En offrant une accélération réseau rapide, efficace et optimisée, les SuperNIC comme le BlueField-3 SuperNIC de NVIDIA sont prêts à révolutionner la façon dont les charges de travail de l’IA sont gérées dans les clouds basés sur Ethernet. Alors que le domaine de l’IA continue de croître et d’évoluer, le rôle des SuperNICs dans la facilitation de cette croissance deviendra sans aucun doute plus important.

Crédit image : NVIDIA