À la pointe de la recherche et du développement en matière d’IA, le DevDay de l’OpenAI a présenté une session passionnante qui a permis de plonger dans les dernières avancées en matière d’intelligence artificielle. La session, qui visait à explorer l’évolution et le potentiel futur de l’IA, s’est particulièrement concentrée sur les technologies de type agent, un domaine qui se développe rapidement dans la recherche sur l’IA. Deux des produits révolutionnaires de l’OpenAI ont été au cœur de cette discussion : GPTs et ChatGPT.

La session a été animée par deux personnalités d’OpenAI : Thomas, l’ingénieur en chef du projet GPTs, et Nick, qui supervise la gestion des produits pour ChatGPT. Ensemble, ils ont raconté le parcours fascinant de ChatGPT, une IA conversationnelle qui a fait des progrès considérables depuis sa création.

Leur présentation a souligné comment ChatGPT, alimenté par GPT-4, représente une nouvelle ère dans l’IA avec ses capacités avancées de traitement du langage naturel, de compréhension de la parole, d’interprétation du code et même d’interaction avec des entrées visuelles. Le duo a souligné que ces développements ont non seulement élargi les horizons techniques de l’IA, mais aussi son applicabilité pratique, ce qui en fait un outil inestimable pour les développeurs et les utilisateurs du monde entier.

Les trois piliers des TPG

Le cœur de la session a tourné autour de l’architecture complexe des TPG, révélant comment ils sont construits à partir de trois composants fondamentaux : les instructions, les actions et les connaissances. Cette triade constitue l’épine dorsale des TPG, fournissant un cadre polyvalent qui peut être adapté et personnalisé en fonction de diverses exigences.

- Instructions (messages du système) : Cet élément sert de force directrice aux TPG, façonnant leur style d’interaction et leurs mécanismes de réponse. Les instructions reviennent à donner à l’IA une personnalité ou une directive spécifique, lui permettant de répondre d’une manière adaptée au contexte ou au thème de l’application.

- Actions : Les actions sont la composante dynamique des TPG qui leur permet d’interagir avec des systèmes et des données externes. Cette connectivité étend la fonctionnalité des TPG au-delà de la simple conversation, leur permettant d’effectuer des tâches, de gérer des données et même de contrôler d’autres systèmes logiciels, ajoutant ainsi une couche d’utilité pratique.

- La connaissance : Le dernier élément est le vaste référentiel d’informations et de données auquel les TPG peuvent accéder et qu’ils peuvent utiliser. Cette base de connaissances n’est pas statique ; elle peut être élargie et affinée pour inclure des ensembles de données spécifiques, ce qui permet aux TPG de fournir des réponses éclairées et adaptées au contexte.

Grâce à cette structure tripartite, les développeurs peuvent créer des versions personnalisées de ChatGPT, en les adaptant à des thèmes, des tâches ou des besoins spécifiques des utilisateurs. La session a mis en évidence la façon dont cette flexibilité ouvre des possibilités infinies d’innovation dans les applications d’IA, faisant des TPG un outil puissant dans l’arsenal de la technologie moderne.

En savoir plus sur les TPG et ChatGPT

Démonstrations en direct : Donner vie aux concepts

La présentation comprenait des démonstrations en direct, illustrant la flexibilité et la puissance des TPG. Par exemple, un GPT sur le thème des pirates a été créé pour illustrer la façon dont les instructions peuvent donner des personnalités uniques à l’IA. Une autre démonstration a porté sur Tasky Make Task Face, un TPG connecté à l’API d’Asana par le biais d’actions, montrant l’application pratique dans la gestion des tâches.

En outre, un GPT nommé Danny DevDay, doté de connaissances spécifiques sur l’événement, a été présenté pour démontrer l’intégration d’informations externes dans les réponses de l’IA.

Présentation de Mood Tunes : Une application créative

Une démonstration particulièrement intrigante a été celle de « Mood Tunes », un maestro de la mixtape. Il combine vision, connaissances et suggestions musicales pour créer une mixtape à partir d’une image téléchargée, mettant en évidence les capacités multimodales de l’IA.

L’API d’assistance : Une nouvelle frontière

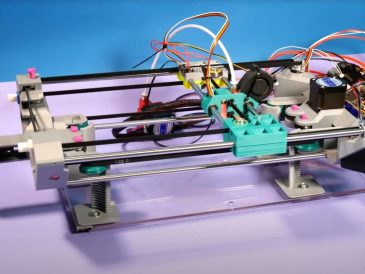

Olivier et Michelle, figures de proue d’OpenAI, ont présenté l’API Assistance. Cette nouvelle API est conçue pour créer des assistants d’IA au sein des applications, en incorporant des outils tels que des interprètes de code, des systèmes de recherche et des appels de fonctions. L’API simplifie la création d’assistants d’IA personnalisés et efficaces, comme le démontrent divers exemples pratiques.

Quelles sont les prochaines étapes pour l’OpenAI ?

La session s’est achevée sur la promesse d’autres avancées, notamment en rendant l’API multimodale par défaut, en permettant l’exécution de codes personnalisés et en introduisant un support asynchrone pour les applications en temps réel. L’engagement d’OpenAI à faire évoluer la technologie de l’IA était clair, puisque l’entreprise a invité la communauté des développeurs à lui faire part de leurs commentaires et de leurs idées.

Lire plus Guide:

- Les nouvelles versions personnalisées des GPT de l’OpenAI et du ChatGPT seront lancées cette semaine

- OpenAI GPT Store ouvre ses portes aux utilisateurs Plus et Enterprise

- Que sont les GPT de l’OpenAI et comment fonctionnent-ils ?

- Création d’actions personnalisées GPT à l’aide d’une clé API OpenAI

- La première Keynote du DevDay 2023 de l’OpenAI dans son intégralité

- OpenAI Asia ouvre son premier bureau à Tokyo, au Japon