L’avènement des grands modèles de langage (LLM) a indéniablement révolutionné le domaine de l’intelligence artificielle. Toutefois, ces modèles ne sont pas exempts de limites. L’un des défis les plus importants auxquels ils sont confrontés est la contrainte des fenêtres contextuelles limitées. Cette limitation entrave leur utilité dans des tâches telles que les conversations prolongées et l’analyse de documents.

Pour résoudre ce problème, une nouvelle technique connue sous le nom de gestion de contexte virtuel a été proposée. S’inspirant des systèmes de mémoire hiérarchique des systèmes d’exploitation traditionnels, cette technique donne l’illusion de grandes ressources de mémoire grâce au mouvement des données entre la mémoire rapide et la mémoire lente. Ce guide présente MemGPT (Memory-GPT), un système qui utilise cette technique pour gérer intelligemment les différents niveaux de mémoire, en fournissant efficacement un contexte étendu dans la fenêtre de contexte limitée du LLM.

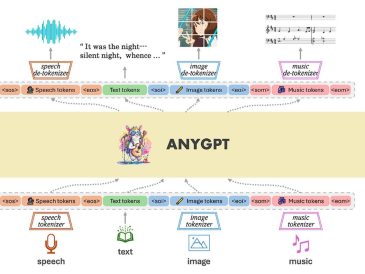

MemGPT est un système qui complète un processeur LLM à contexte fixe avec un système de mémoire à plusieurs niveaux et un ensemble de fonctions qui lui permettent de gérer sa propre mémoire. Le contexte principal est l’entrée LLM de longueur fixe. MemGPT analyse les sorties de texte LLM à chaque cycle de traitement et cède le contrôle ou exécute un appel de fonction. Ces appels de fonction peuvent être utilisés pour déplacer des données entre le contexte principal et le contexte externe. Lorsque le LLM génère un appel de fonction, il peut demander un retour immédiat de l’exécution pour enchaîner les fonctions. Dans le cas d’un yield, le LLM ne sera pas exécuté à nouveau jusqu’au prochain déclenchement d’un événement externe, tel qu’un message utilisateur ou une interruption programmée.

Une introduction à MemGPT

Le concept de MemGPT s’inspire de la mémoire virtuelle des systèmes d’exploitation, qui est utilisée pour créer un contexte LLM non limité. Ceci est particulièrement utile dans le contexte des chats perpétuels, où les longueurs de contexte limitées peuvent rendre le processus difficile. Avec MemGPT, les LLM peuvent apprendre à gérer leur propre mémoire, surmontant ainsi les limites des longueurs de contexte fixes.

L’utilité de MemGPT va au-delà des discussions perpétuelles. Il a été évalué dans deux domaines où les fenêtres contextuelles limitées des LLM modernes handicapent gravement leurs performances : l’analyse de documents et le chat multisession. Dans le cas de l’analyse de documents, MemGPT est capable d’analyser des documents volumineux qui dépassent de loin la fenêtre contextuelle du LLM sous-jacent. Il s’agit d’une avancée significative, car elle permet une analyse plus complète et plus approfondie de grands volumes de texte.

Dans le domaine du chat multisession, MemGPT peut créer des agents conversationnels qui se souviennent, réfléchissent et évoluent de manière dynamique grâce à des interactions à long terme avec leurs utilisateurs. Il s’agit d’une avancée significative dans le développement des chatbots d’IA, car elle permet des conversations plus naturelles et engageantes qui peuvent évoluer au fil du temps.

MemGPT représente une avancée significative dans le domaine des grands modèles de langage. En gérant intelligemment différents niveaux de mémoire et en fournissant un contexte étendu dans la fenêtre contextuelle limitée du LLM, il surmonte certaines des principales limitations de ces modèles. Qu’il s’agisse de permettre une analyse plus complète des documents ou de faciliter des conversations plus engageantes et plus dynamiques dans les chats multi-sessions, les applications potentielles de MemGPT sont vastes et passionnantes. Alors que nous continuons à repousser les limites de ce qui est possible avec les grands modèles de langage, des systèmes comme MemGPT joueront sans aucun doute un rôle crucial dans le façonnement de l’avenir de ce domaine.

Lire plus Guide:

- Un autre aperçu de toutes les nouvelles fonctionnalités de ChatGPT

- Intégration de grands modèles de langage d’IA LLM avec les graphes de connaissances

- Renforcez l’intelligence de votre grand modèle linguistique (LLM) d’IA local

- Comment utiliser Google Gemini pour stimuler votre productivité

- ChatGPT Basic vs ChatGPT Plus, cela vaut-il la peine de passer à la version supérieure ?

- ChatGPT Les dernières mises à jour pourraient constituer un pas en arrière pour les chercheurs en raison de la dérive de l’IA